[Spark] map, reduce 활용

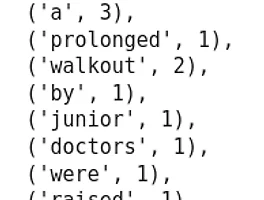

map, reduce 활용 예제 wordcount word_counts = text.flatMap(lambda line:line.split()).map(lambda word : (word, 1)).reduceByKey(lambda x,y : x+y) word_counts.collect() 모두 2 곱하기 numbers = spark.sparkContext.parallelize([1,2,3,4,5,6,7,8,9]) numbers.map(lambda x : x*2).collect() 짝수만 필터링 numbers.filter(lambda x : x%2 == 0).collect() 모든 요소의 합 구하기 numbers.reduce(lambda x,y : x+y) 각 요소의 길이 # 각 요소의 길이 text = ..

[Spark] map, reduce 활용

map, reduce 활용 예제 wordcount word_counts = text.flatMap(lambda line:line.split()).map(lambda word : (word, 1)).reduceByKey(lambda x,y : x+y) word_counts.collect() 모두 2 곱하기 numbers = spark.sparkContext.parallelize([1,2,3,4,5,6,7,8,9]) numbers.map(lambda x : x*2).collect() 짝수만 필터링 numbers.filter(lambda x : x%2 == 0).collect() 모든 요소의 합 구하기 numbers.reduce(lambda x,y : x+y) 각 요소의 길이 # 각 요소의 길이 text = ..

[Spark] join 연산, csv, json, Parquet, ORC

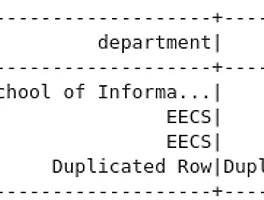

join person = spark.createDataFrame([ (0, "Bill Chambers", 0, [100]), (1, "Matei Zaharia", 1, [500, 250, 100]), (2, "Michael Armbrust", 1, [250, 100])])\ .toDF("id", "name", "graduate_program", "spark_status") graduateProgram = spark.createDataFrame([ (0, "Masters", "School of Information", "UC Berkeley"), (2, "Masters", "EECS", "UC Berkeley"), (1, "Ph.D.", "EECS", "UC Berkeley")])\ .toDF("id", ..

[Spark] join 연산, csv, json, Parquet, ORC

join person = spark.createDataFrame([ (0, "Bill Chambers", 0, [100]), (1, "Matei Zaharia", 1, [500, 250, 100]), (2, "Michael Armbrust", 1, [250, 100])])\ .toDF("id", "name", "graduate_program", "spark_status") graduateProgram = spark.createDataFrame([ (0, "Masters", "School of Information", "UC Berkeley"), (2, "Masters", "EECS", "UC Berkeley"), (1, "Ph.D.", "EECS", "UC Berkeley")])\ .toDF("id", ..